L’humanité déploie de tels trésors d’intelligence (on le constate tous les jours en côtoyant certains de nos semblables…) qu’il peut sembler vain de tenter de l’imiter. C’est pourtant le Graal des informaticiens, en quête depuis toujours du cerveau artificiel. Et de ses diverses applications comme le machine learning, par exemple.

Intelligence artificielle ?

La récolte d’informations, leur perception et leur compréhension, l’organisation du raisonnement sont des facultés propres à l’intelligence humaine qui nous semblent naturelles mais ne le sont guère pour les machines. L’intelligence artificielle en tant que discipline scientifique s’attache aux outils et techniques qui permettent à un système informatique de reproduire les capacités intellectuelles au plus proche de celles des humains.

Cette discipline a connu un fort engouement à partir des années 70, suscitant de nombreux espoirs mais les résultats concrets ont été particulièrement décevants jusqu’à la fin des années 90. Pas si facile d’imiter l’imbécile moyen… Pourtant, ces dernières années, grâce à la forte demande de ces technologies, l’AI (artificial intelligence) a refait surface.

Avec la montée en puissance des capacités de calculs et de stockages des ordinateurs, l’approche a évoluée vers l’apprentissage automatique et les statistiques. C’est en effet sur ces points que l’intelligence artificielle peut dépasser l’humain et même l’expert. Une machine et sa quirielle de logiciels a la possibilité à faire des calculs complexes en s’appuyant sur de très grandes bases de données, avec de nombreuses possibilités d’automatisations.

A la pointe de l’innovation scientifique, StartMe Up est une société grenobloise qui réunit des experts en mathématiques, informatique et diverses sciences de l’information.

Ils travaillent à l’élaboration d’algorithmes et autres outils avancés pour proposer des applications concrètes utilisant l’intelligence artificielle.

Ils travaillent à l’élaboration d’algorithmes et autres outils avancés pour proposer des applications concrètes utilisant l’intelligence artificielle.

A quoi sert l’intelligence artificielle ?

On n’imagine pas à quel point ces technologies vont bouleverser nos vies dans les années à venir. Et le processus est déjà largement engagé. Les techniques de Data Mining, par exemple, permettent de mettre littéralement « à poil » un individu, en exploitant les masses de données le concernant, accessibles légalement ou de manière occulte. Des logiciels sont déjà capables aujourd’hui de croiser les informations de type Facebook, les cookies de nos ordinateurs qui gardent traces de nos navigations sur l’Internet, nos relevés de cartes bancaires, nos divers titres de transport et les données de géolocalisation que nous mettons sans broncher à disposition par le truchement de nos chers téléphones portables. Ceci permet de dresser un portrait robot extrêmement fidèle de tout un chacun et, mieux, de prévoir avec une exactitude confondante nos réactions et choix à venir en matière de consommation ou autre…

Mais toutes les applications de ce domaine ne sont pas aussi pernicieuses. Différents secteurs d’activité ont besoin d’automatiser des procédés traités manuellement, afin de réduire les coûts ou d’améliorer la productivité. En jeu également le besoin d’innovations pour garder une longueur d’avance sur la concurrence. L’apprentissage automatique par exemple, permet de dépasser les méthodes algorithmiques classiques et rend possible la création d’outils et processus « intelligents ».

Aujourd’hui, le machine learning, est considéré comme le domaine le plus productif de l’intelligence artificielle, démontrant ses performances dans des disciplines telles que la vision par ordinateur, le traitement automatique de la langue, ou la recherche d’informations. En effet, les données, quelque soient leurs formes, sont porteuses d’informations utiles à partir desquelles une machine peut apprendre un phénomène dans le but de prédire des données futures. A partir d’un ensemble de données existantes dites d’apprentissage, les outils de modélisation statistique vont tenter de mettre au point un modèle de prédictions le plus pertinent possible. Contrairement aux approches traditionnelles régies par des règles, le modèle va pouvoir s’enrichir au cours du temps, au fur et à mesure que de nouvelles données se présenteront. La machine pourra aussi évoluer grâce à des retours provenant d’utilisateurs ou d’experts, de façon à améliorer la qualité des modèles.

On retrouve aujourd’hui ces techniques dans un grand nombre de secteurs :

« Traitement de textes »

« Traitement de textes »

Analyse de sentiments et d’opinions

Labelisation ou Tagging automatique

Analyse sémantique de documents

Classification de documents

Analyse de tweets en temps réel

Extraction et analyse automatique de news

Images et vidéos

Reconnaissance de visages ou d’objets

Traitement automatique des vidéos

Utilisateurs

Système adaptatif à l’utilisateur

Recommandations personnalisées

Analyse des comportements abusif

Extraction d’informations

Analyse de réputation

Analyse de réseaux sociaux

Extraction d’entités structurées

Veille stratégique

Analyse de données

Aide à la décision

Détection d’anomalies

Les enjeux sont énormes. Comprendre le sens porté par un texte peut se révéler utile pour différentes problématiques d’analyse automatique de documents, en particulier dans les domaines de recherche ou d’extraction d’informations, dans l’analyse de sentiments ou d’opinions, le dialogue homme machine ou la traduction automatique. Les contenus textuels sont porteur de sens que l’humain peut comprendre sans difficultés. Pour une machine la tâche n’est pas si simple car la sémantique fait référence à un grand nombre de connaissances d’arrière plan qui sont difficilement modélisables sur une machine par les approches algorithmiques classiques. Mais, grâce à l’apprentissage machine (machine learning) cette difficulté est en passe d’être contournée.

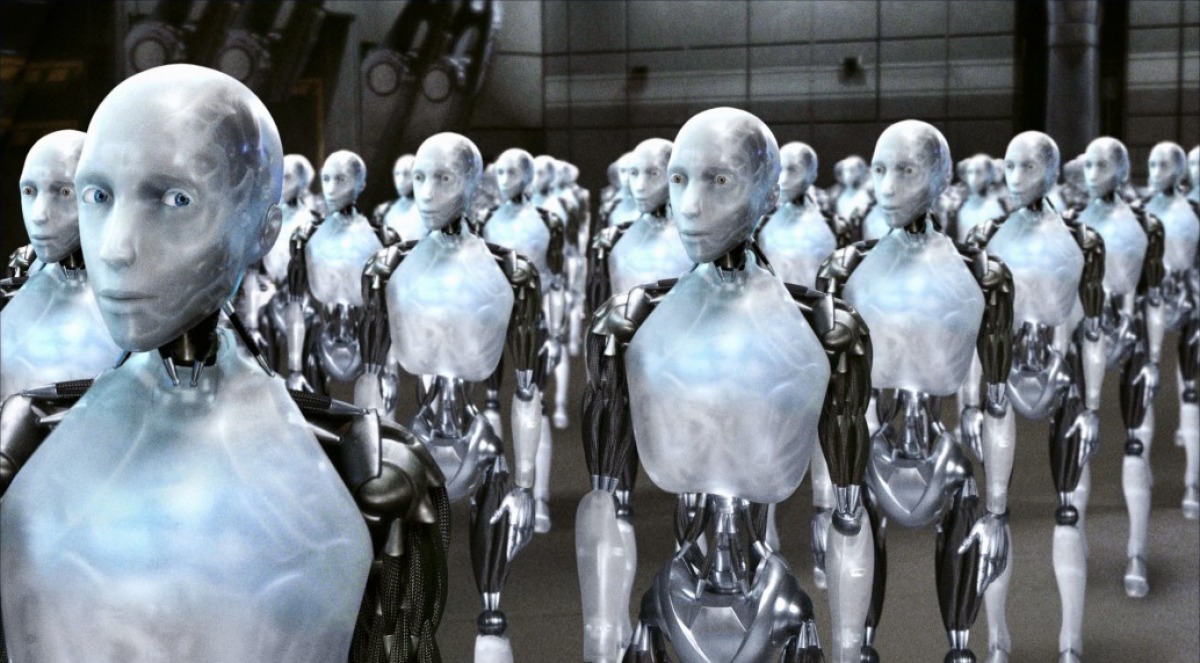

Nous ne sommes plus très loin du moment où, au cours d’une transaction quelconque, il sera impossible de dire si l’on à affaire à un homme (voire une femme :-)) ou à un programme. Si vous êtes des habitués des « hotlines » décentralisées au Maroc, à Maurice ou aux Philippines, vous voyez déjà comment on peut transformer des humains en robots…

Au début de l’internet sévissait cet adage : « Sur internet, personne ne sait que vous êtes un chien »…

Mieux qu’un perroquet !

Pour s’en convaincre, rien de tel que de jouer avec quelques robots sémantiques en ligne. Par exemple Alice (Artificial Intelligence Foundation) ou le plus ancien ELIZA… On peut discuter des heures avec ces robots, qui font illusion. Au moins autant que les robots utilisés systématiquement sur les sites cochons et payants, exploitant ainsi la misère humaine…

ELIZA en son temps, valait largement une séance de psychanalyse puisque ce programme informatique écrit par Joseph Weizenbaum en 1966, simule un psychothérapeute rogérien en reformulant simplement la plupart des affirmations du « patient », et en les lui soumettant sous forme de nouvelles questions.

Weizenbaum insiste dans son livre sur le fait que même si ELIZA écrit : «Je comprends…», il s’agit évidemment d’une déclaration abusive. ELIZA est bête comme ses bits et ne comprend en réalité rien du tout. L’algorithme se contente de former des phrases à partir de modèles pré établis, enrichis par les mots clés trouvés dans les réponses du patient.

Mais ELIZA était si convaincante que beaucoup de gens devenaient de plus en plus dépendants émotionnellement de leur relation avec « Elle » ! Ceci s’explique par la tendance naturelle humaine à attacher aux mots des sens que l’ordinateur ne pouvait y avoir mis. Par ailleurs, la grande faiblesse d’ELIZA (être incapable de répondre quoi que ce soit de concret, se contentant de continuer à faire parler son interlocuteur), était en fait un atout. Certaines personnes ne souhaitent pas vraiment qu’on leur réponde, et ne remarquent pas si leur interlocuteur les comprend. Il suffit de leur donner l’impression qu’elles sont écoutées…

Le test de Turing

Alors, est-il toujours possible de faire la différence entre un humain et un robot ? Je ne parle pas ici de ces captchas imbéciles, ces lettres et chiffres volontairement indéchiffrables à taper pour accéder à des sites Web et qui pour le coup nous font douter d’être des humains et nous forcent en tout cas à prendre rendez vous d’urgence avec l’ophtalmologiste !

Alors, est-il toujours possible de faire la différence entre un humain et un robot ? Je ne parle pas ici de ces captchas imbéciles, ces lettres et chiffres volontairement indéchiffrables à taper pour accéder à des sites Web et qui pour le coup nous font douter d’être des humains et nous forcent en tout cas à prendre rendez vous d’urgence avec l’ophtalmologiste !

Mathématicien anglais, Alan Turing est l’inventeur de l’ordinateur moderne. Il a également imaginé un test pour répondre à cette question existentielle : une machine peut-elle penser ?

Le test de Turing est une proposition de test d’intelligence artificielle fondée sur la faculté d’imiter la conversation humaine. Il consiste à mettre en confrontation verbale un humain avec un ordinateur et un autre humain à l’aveugle. Si l’homme qui engage les conversations n’est pas capable de dire lequel de ses interlocuteurs est un ordinateur, on peut considérer que le logiciel de l’ordinateur a passé avec succès le test. Cela sous-entend que l’ordinateur et l’homme essaieront d’avoir une apparence sémantique humaine. Pour conserver la simplicité et l’universalité du test, la conversation est limitée à un échange textuel entre les protagonistes.

Le test a été inspiré d’un jeu d’imitation dans lequel un homme et une femme vont dans des pièces séparées et les invités tentent de discuter avec les deux protagonistes en écrivant des questions et en lisant les réponses qui leur sont renvoyées. Dans ce jeu l’homme et la femme essayent de convaincre les invités qu’ils sont tous deux des femmes.

Plonge la pomme dans le brouet et laisse le sommeil de la Mort l’imprégner…

Voilà qui résonne douloureusement quand on sait que Turing était homosexuel et que la répression qui sévissait alors l’a poussé au suicide. En 1954, peu après avoir été condamné par la justice de son pays à la castration chimique, il s’est donné la mort en croquant une pomme empoisonnée au cyanure à la manière de Blanche Neige, film qui l’avait fortement marqué.

C’est également l’origine (controversée) du symbole d’Apple, mais ceci, est une autre histoire…

Demain, tous robots ?

Les articles du BloGuen sont toujours bien faits et intéressants, sans oublier une touche d’humour, propre à l’auteur 😉

Merci Philippe 😉

Comme le disait Perlis ( http://www.drgoulu.com/2008/01/21/perlisismes-les-dictons-informatiques-dalan-perlis/ ) : « Une année de travail sur l’intelligence artificielle est suffisante pour vous faire croire en Dieu. »

J’ai arrêté après 11 mois… Chaque fois qu’on parle d’intelligence artificielle je repense à mes cours sur le sujet il y a 25 ans où le prof nous disait qu’on progressait rapidement dans le domaine de la bêtise artificielle…

Aujourd’hui je dirais que les applications d’intelligence artificielle existantes ont progressé au rythme de la Loi de Moore, mais qu’aucun des objectifs de l’ « ordinateur de la 5ème génération » que les japonais nous promettaient il y a 35 ans n’a été atteint. Mais ce n’est pas une raison pour arrêter les efforts car « Quand nous écrivons des programmes qui « apprennent », ce qui arrive c’est que nous apprenons, et eux pas. » 🙂

Merci Docteur de ce réjouissant commentaire ! J’aime particulièrement « la bêtise artificielle » 🙂

Votre blog est passionnant et pointu comme j’aime, Goulu !